人工知能(AI)の進化に伴い、私たちの日常生活におけるAIの利用が急速に増えています。その中でも、特に注目を集めているのがOpenAIのChatGPTです。しかし、この強力なツールにもいくつかの課題が存在します。その一つが「ハルシネーション」と呼ばれる現象です。ChatGPTのハルシネーションとは、AIが存在しない情報を生成したり、誤った回答を提供したりする現象を指します。

本記事では、ChatGPTのハルシネーション現象について詳しく解説し、その原因や影響、そして具体的な対策について探ります。ハルシネーションの理解を深めることで、より安全かつ効果的にChatGPTを利用するための知識を身に付けましょう。

tano

tano・ITパスポート資格持ち

・有料版ChatGPT Plus加入者で、ビジネスシーンにおいて現在進行形でChatGPTを使っている

そんな私がわかりやすく解説していきます!

ChatGPTにおけるハルシネーションとは?

ハルシネーション(Hallucination:幻覚)とは、AIが事実に基づかない情報を生成する現象を指します。

誤った情報を、まるで正解であるかのように、もっともらしい情報として出力すること。

たとえば、実際には存在しない人物や出来事について語ったり、事実とは異なる誤ったデータを提供することがあります。この現象は、AIのトレーニングデータやアルゴリズムの限界に起因しています。AIは膨大なデータを元に学習しますが、その中には誤った情報が含まれていることもあります。

ChatGPTは、OpenAIによって開発された会話型人工知能ですが、どれほど優れたAIにもハルシネーションの可能性があります。これによってユーザーが混乱したり、誤情報を受け取ったりする原因になり得るため、この問題の理解と対策は非常に重要です。

ハルシネーションの原因

ChatGPTのハルシネーションは主に、訓練データの問題、モデルの限界、または入力データの不具合によって発生します。AIは大量のテキストデータから学習しますが、そのデータに偏りや誤りがある場合、それがそのままAIのレスポンスに反映されることがあります。また、AIがまだ完全には理解していない複雑な質問や未知のトピックに対して答える際にも、ハルシネーションが生じやすいです。

データの質と量

AIは膨大なデータを使って学習しますが、そのデータの質や量が重要です。不正確な情報が含まれている場合、AIはそれを学習し、誤った結果を生成することがあります。また、特定のテーマに関するデータが不足している場合も、AIはハルシネーションを起こしやすくなります。

自然言語処理を優先してしまう

AIの自然言語処理は、学習されてきたパターンによるものです。会話の流れ、人間的な回答、共起語の出現パターンなどを優先して回答に盛り込もうとするとき、内容的に正しいかどうかの精査ができていない回答があらわれる場合があります。

プロンプトの文脈・意図が伝わらない

AIは文脈を理解する能力に限界があります。そのため、複雑な質問や曖昧な表現に対して正確に回答することが難しい場合があります。文脈を正確に理解できないと、AIは関連性のない情報を生成することがあります。

ハルシネーションの影響

ChatGPTのハルシネーションは、誤った情報を提供することでユーザーに混乱を招き、信頼性を損なう可能性があります。特に、医療や法律などの専門的な分野においては、誤った情報が重大な結果を招くことがあります。対策を講じてハルシネーションを予防するか、ミスが許されないシーンでは、AIの運用を控える必要があります。

- 個人情報への影響

-

【プライバシーの侵害】ハルシネーションにより、ChatGPTが実際には存在しない個人情報を生成する場合があります。このような誤情報が第三者に渡った場合、無実の人が誤解されたり、プライバシーが侵害されるリスクがあります。また、生成した情報によって意図しない個人に迷惑がかかる可能性があります。

- 権利への影響

-

【名誉毀損】誤った情報が生成されることで、特定の個人や団体の名誉が傷つけられることがあります。ChatGPTが虚偽の事実を述べることで、その対象者が社会的に不利益を被るリスクがあります。これは名誉毀損に該当し、深刻な問題に発展する可能性があります。

-

【知的財産権の侵害】ハルシネーションにより、ChatGPTが既存の著作物や発明に近しいものを誤って生成することがあります。既存の作品を参考にしていないにもかかわらず、似たような内容を生成することで、著作権の問題が発生する可能性があります。

ハルシネーションの対策方法

ハルシネーションを防ぐための対策方法は、AIに明確かつ具体的な質問をすることです。また、AIからの回答が疑わしい場合は、信頼できる情報源で確認を行うことが重要です。OpenAIでは、ハルシネーションの問題を軽減するための対策方法として、モデルのアップデートや訓練データの改善に努めています。

対策➀データの精査と更新

AIの学習データを定期的に精査し、正確な情報で更新することが重要です。不正確なデータや古い情報を排除することで、AIの精度を向上させることができます。

対策②ユーザーのフィードバック

ユーザーからのフィードバックを積極的に収集し、AIの改善に役立てることが重要です。誤った情報が提供された場合、その情報を訂正し、AIの学習データに反映させることで、ハルシネーションの発生を減少させることができます。

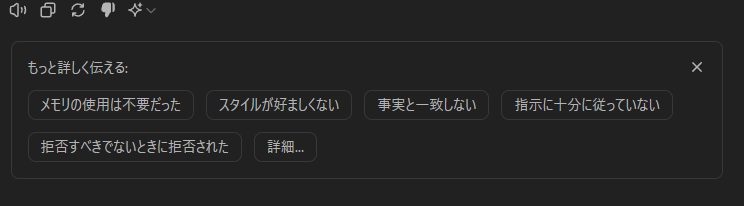

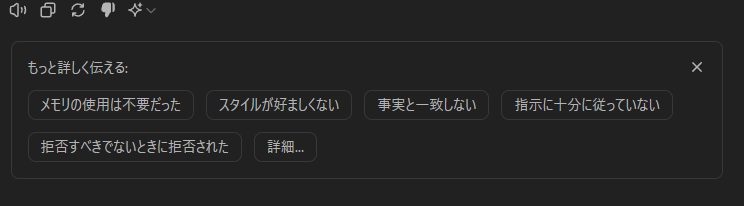

回答がずれていたり、誤った情報だったりしたときには、積極的にフィードバックを返しましょう。回答の下にあるマークから内容を選択することができます。

対策③プロンプトの文脈を明確化する

ユーザーは質問をする際に、できるだけ具体的で明確な文脈を提供することが重要です。曖昧な質問や複雑な表現を避けることで、AIが正確な情報を提供しやすくなります。

対策④定期的な評価とテスト

AIの性能を定期的に評価し、テストすることで、ハルシネーションの発生状況を把握し、改善点を特定することができます。これにより、AIの精度と信頼性を向上させることができます。

まとめ

ChatGPTにおけるハルシネーションの対策方法や原因について解説してきました。

AI技術の進化は私たちの生活を便利にする一方で、新たな課題も生み出しています。ChatGPTのハルシネーション問題もその一つです。AIにおけるハルシネーションは、完全にゼロにすることはできません。しかし、適切な知識と対策を持つことで、これらの問題を乗り越え、AIの恩恵を最大限に享受することが可能です。この記事を通じて、ChatGPTのハルシネーションについての理解を深め、その予防策を身に付けましょう。

以上、「ChatGPTにおけるハルシネーション|対策方法と原因・影響」でした。最後まで読んで下さり、ありがとうございました。

コメント